如何本地部署deepseek-r1

环境介绍 🌟

在本教程中,我们将详细介绍如何在本地部署两个版本的 DeepSeek-R1 大模型,分别是 8b 和 14b 版本。8b 版本推理速度较快,适合快速响应需求;而 14b 版本虽然推理速度稍慢(平均等待时间 10-20 秒),但模型能力更强,适合对精度要求较高的任务哦~ 😊

硬件配置 💻

- 操作系统:Microsoft Windows 11 专业版 Build 26100 64 位

- 处理器:AMD Ryzen 7 6800H

- 内存:海力士 DDR5 4800 MHz 40G

- 显卡:NVIDIA GeForce RTX 3050 Ti Laptop GPU

部署步骤 🛠️

1. 安装 Ollama

首先,我们需要安装 Ollama,这是一个用于管理和运行大模型的工具。别担心,安装过程很简单! 😄

-

访问 Ollama 官网:https://ollama.com/

-

下载并安装 Ollama:根据你的操作系统选择合适的安装包进行下载。安装过程中,默认会将 Ollama 安装在 C 盘,因此请确保 C 盘有足够的空间(建议 ≥ 12G)用于安装 Ollama 及后续的大模型哦~ 🚀

-

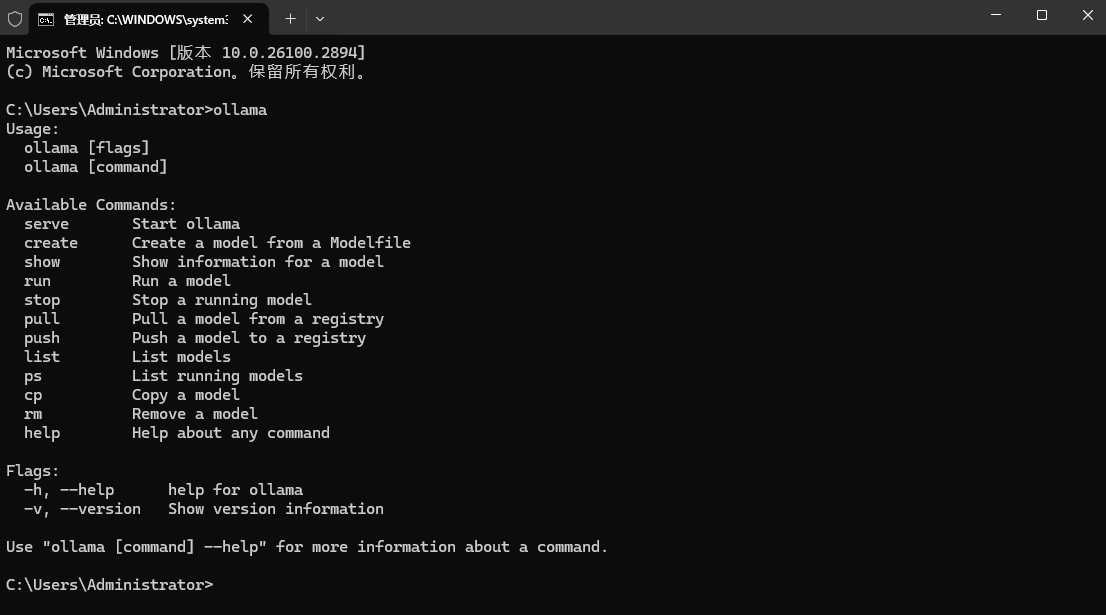

验证安装:安装完成后,打开命令提示符(cmd),输入

ollama。如果出现类似以下的输出,说明 Ollama 已经成功安装并可以正常使用啦! 🎉

2. 部署 DeepSeek-R1

接下来,我们将部署 DeepSeek-R1 大模型。根据你的需求,可以选择部署 8b 或 14b 版本。让我们开始吧! 😎

-

打开任务管理器:以管理员身份运行任务管理器。

-

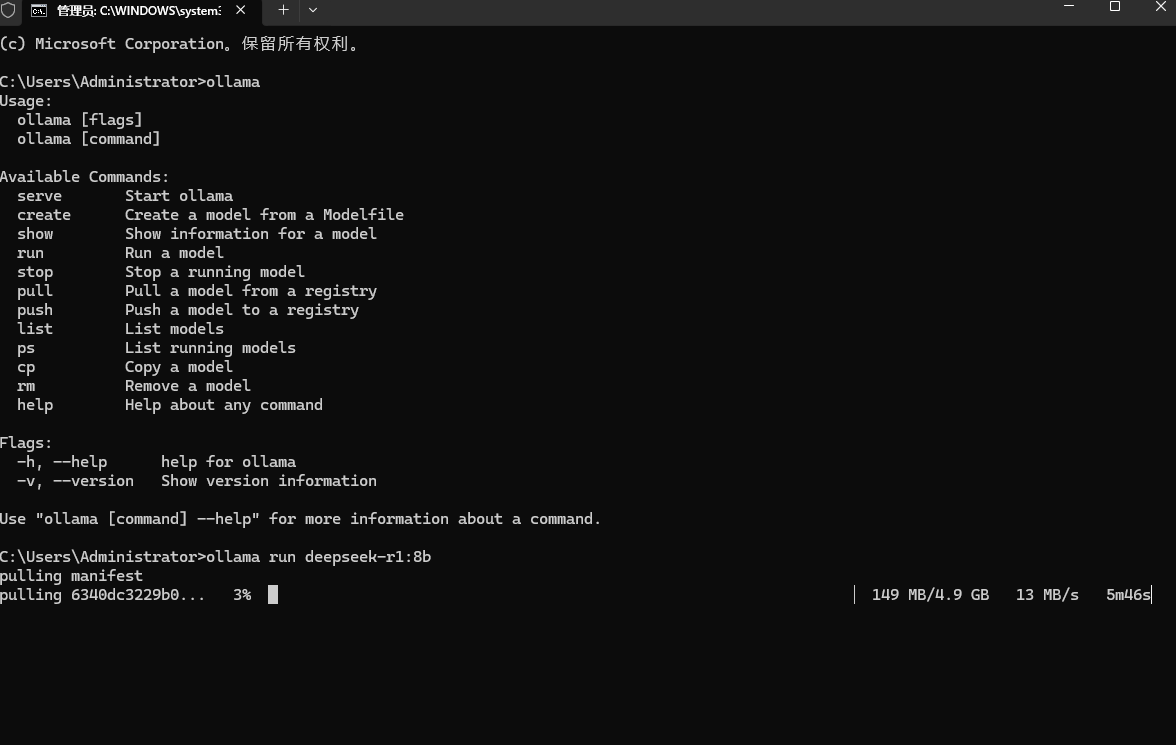

输入部署命令:

- 如果你需要部署 8b 版本,输入以下命令:

ollama run deepseek-r1:8b - 如果你需要部署 14b 版本,输入以下命令:

ollama run deepseek-r1:14b

部署过程中,Ollama 会自动下载所需的模型文件。请确保网络连接稳定,并且有足够的磁盘空间哦~ 🌐

- 如果你需要部署 8b 版本,输入以下命令:

- 如果要运行模型只需要

ollama run 模型名称

验证安装 ✅

部署完成后,我们可以通过以下命令来验证安装是否成功:

-

查看 Ollama 版本:运行以下命令查看 Ollama 的版本号:

ollama -v如果显示版本号,说明 Ollama 已正确安装啦! 🎈

-

查看已安装模型:运行以下命令查看所有已安装的模型:

ollama list你应该能看到

deepseek-r1:8b或deepseek-r1:14b在列表中。是不是很简单呢? 😉 -

删除模型(可选):如果你不再需要某个模型,可以通过以下命令删除:

ollama rm 模型名称例如,删除

deepseek-r1:8b模型:ollama rm deepseek-r1:8b

如何更改模型下载位置(可选) 📂

默认情况下,Ollama 会将模型下载到 C 盘。如果你希望将模型下载到其他位置,可以通过以下步骤进行设置:

-

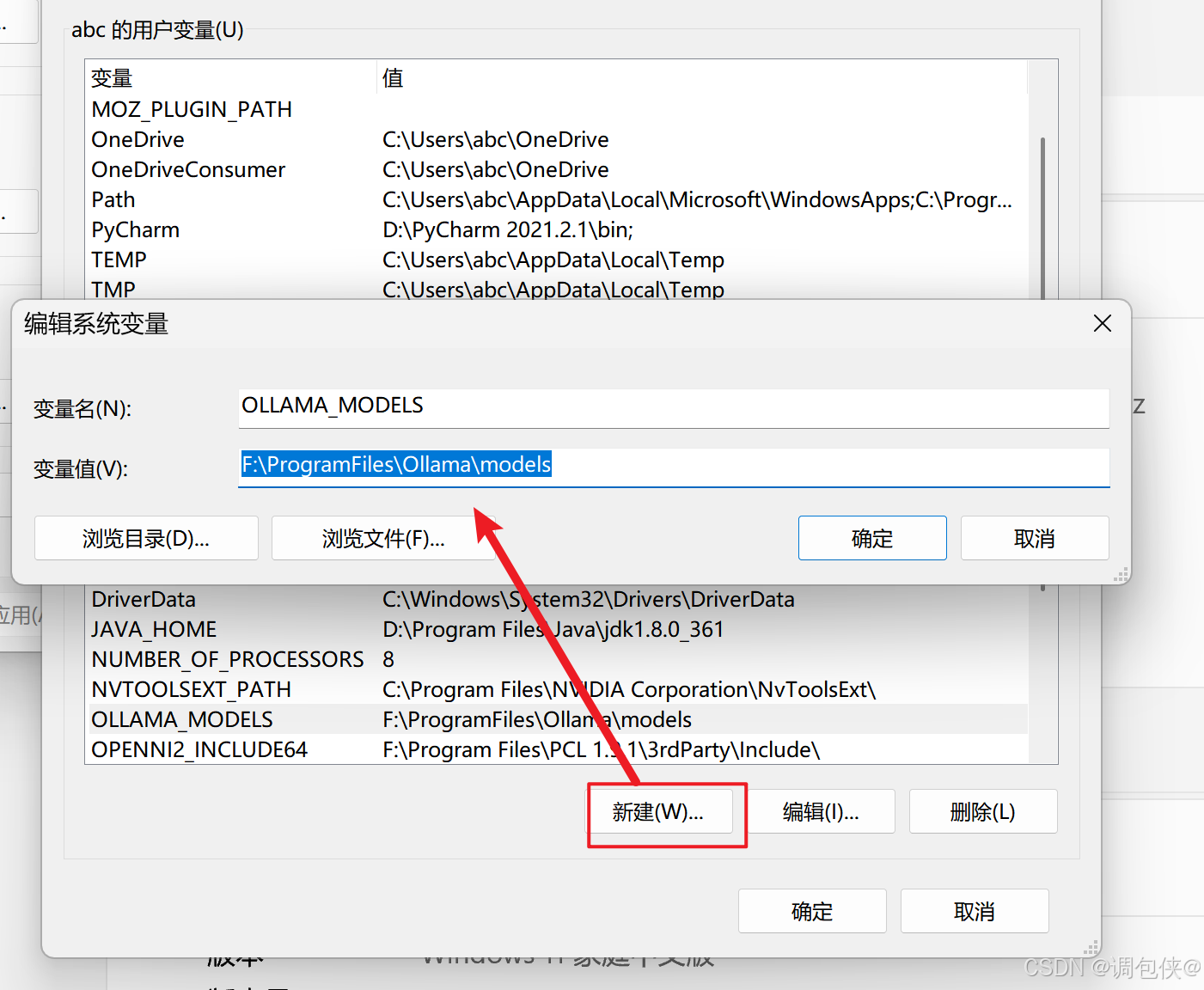

新建环境变量:

- 右键点击“此电脑”或“我的电脑”,选择“属性”。

- 点击“高级系统设置”,然后点击“环境变量”。

- 在“系统变量”部分,点击“新建”。

- 输入变量名

OLLAMA_MODELS,变量值为你希望模型下载到的路径,例如F:\ollama\models。

-

重启 Ollama 或 PowerShell:设置完成后,重启 Ollama 或 PowerShell,模型下载位置将会迁移到你指定的路径。这样就不用担心 C 盘空间不足啦! 😄